探索本地 AI:快速上手 Ollama (Windows)

大家好!是否期望在自己的电脑上感受人工智能的非凡魅力呢?今日,我们一同来研习如何运用 Ollama,此乃一个可让你在本地运行(也可以放在 u盘等移动设备中)大型语言模型的工具。无需忧虑,即便你是编程领域的新手,亦能轻松驾驭。

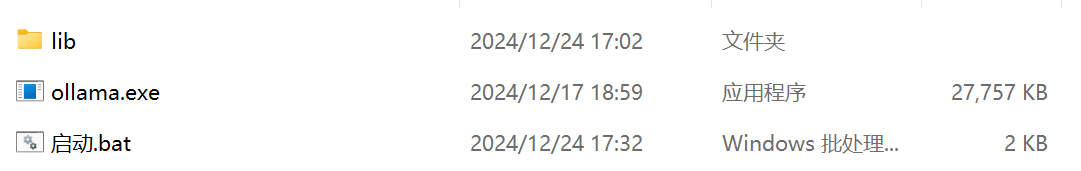

我们手中存有一个名为“ollama-windows-amd64”的压缩包,其犹如一个工具箱,内部装载着运行 AI 模型所必需的各类组件。让我们共同开启这个工具箱,探究如何对其加以使用。

准备工作:找到你的“工具箱”

首先,点击这个下载链接下载文件(备用下载链接,需翻墙)(链接失效请在评论区留言)找到你下载的 ollama-windows-amd64 压缩包。 就像下图展示的那样,它包含了一些关键的文件和文件夹:

其中,有两个文件是我们最需要关注的:

启动.bat: 这是一个批处理脚本,相当于一个自动执行命令的小程序。我们通过运行它来启动 Ollama。ollama.exe: 这就是 Ollama 应用程序本身,负责运行各种 AI 模型。

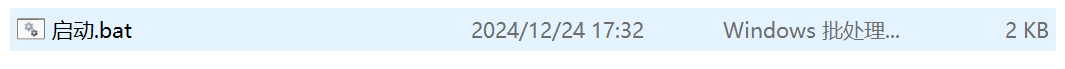

第一步:启动 Ollama 服务

找到名为 启动.bat 的文件,就像下图所示:

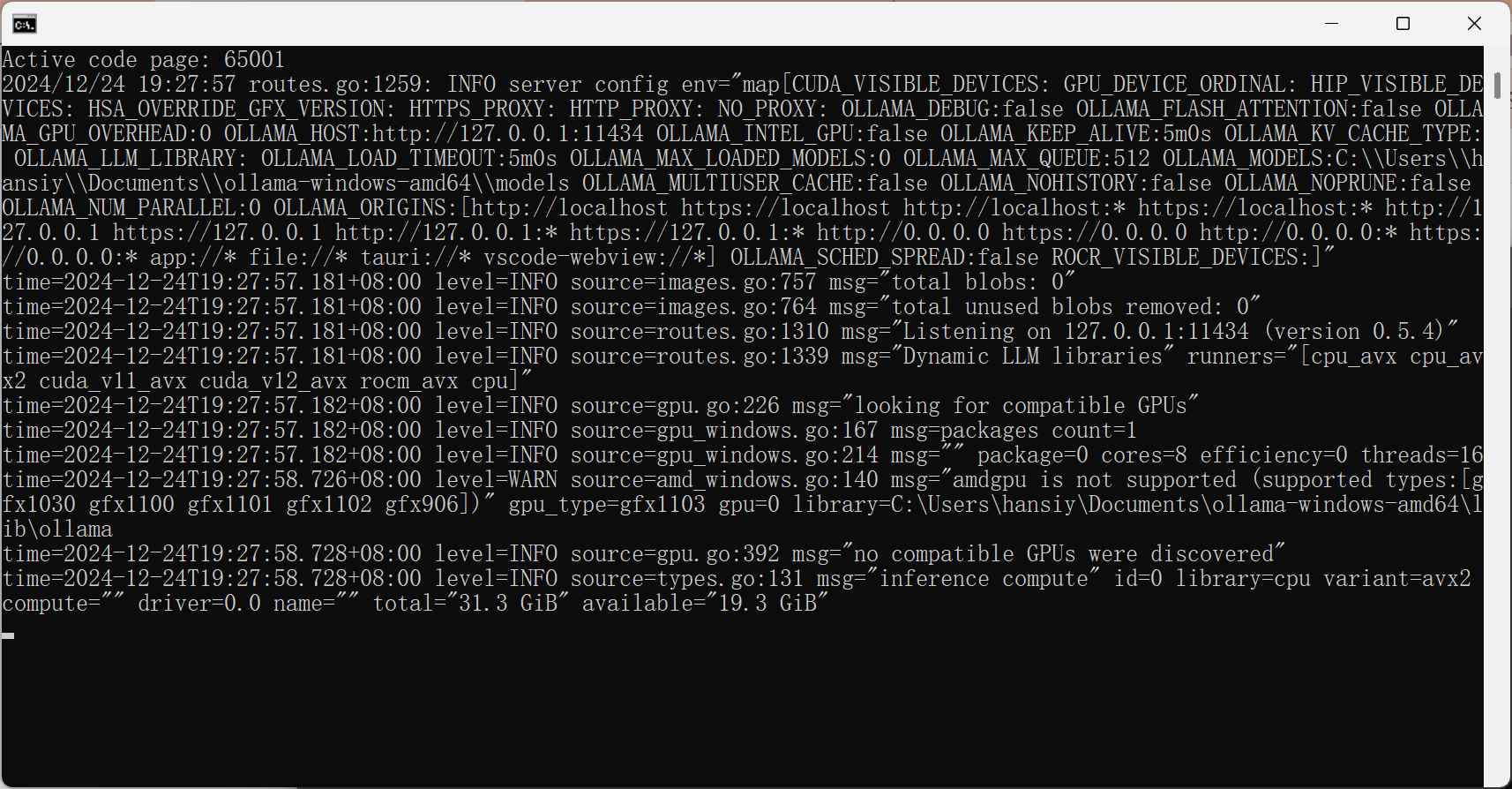

双击这个文件(快速点击鼠标左键两次)。你会看到电脑上弹出了两个黑色的命令行窗口 (CMD)。

不用担心,这是正常的。 第一个窗口运行的是 Ollama 的服务器端,它会在后台默默工作,负责加载和管理 AI 模型。你可以暂时不用管它。

启动.bat 脚本解析 (可选了解,可跳过):

如果你对技术细节感兴趣,可以简单了解一下 启动.bat 脚本的内容:

@echo off

setlocal

:: 设置控制台编码为 UTF-8

chcp 65001 > nul

:: 获取脚本所在目录

set SCRIPT_DIR=%~dp0

:: 设置模型目录 (可以修改为其他路径)

set OLLAMA_MODELS=%SCRIPT_DIR%models

:: 确保 models 目录存在

if not exist "%OLLAMA_MODELS%" (

echo 创建模型目录: %OLLAMA_MODELS%

mkdir "%OLLAMA_MODELS%"

)

:: 检查 ollama.exe 是否存在

if not exist ".\ollama.exe" (

echo 错误: 找不到 ollama.exe! 请确保 ollama.exe 与脚本在同一目录下。

pause

exit /b 1

)

:: 切换到 ollama 目录 (假设 ollama.exe 与脚本在同一目录)

cd %SCRIPT_DIR%

:: 启动Ollama Server (最小化窗口)

echo 正在启动 Ollama Server...

start "" /min cmd /k "chcp 65001 & .\ollama.exe serve"

:: 延迟一段时间,确保 Ollama Server 启动完成 (根据实际情况调整)

timeout /t 2 /nobreak > nul

:: 获取可用的模型列表

echo 可用的模型列表:

for /f "skip=1 tokens=1" %%a in ('".\ollama.exe" list') do echo %%a

echo.

:: 提示用户输入模型名称

set /p MODEL_NAME="请输入要运行的模型名称 (可在 https://ollama.com/library 搜索,直接回车使用 qwen:0.5b):"

:: 如果用户直接回车,使用默认模型 qwen:0.5b

if "%MODEL_NAME%"=="" set MODEL_NAME=qwen:0.5b

:: 打开新 cmd,设置相同的环境变量并执行 ollama run 命令

echo 正在启动 Ollama Client cmd 窗口并执行 ollama run %MODEL_NAME%...

start "Ollama Client" cmd /k "chcp 65001 & set OLLAMA_MODELS=%OLLAMA_MODELS% & .\ollama.exe run %MODEL_NAME%"

echo Ollama服务和客户端启动完成。

echo 请在新打开的客户端窗口中与模型进行交互。

endlocal

pause

这个脚本主要做了以下几件事:

- 设置命令行窗口的字符编码为 UTF-8,以支持中文显示。

- 确定脚本所在的目录。

- 设置一个用于存放模型文件的目录。

- 检查

ollama.exe是否存在。 - 启动 Ollama 服务 (server)。

- 启动一个新的命令行窗口,并在这个窗口中运行指定的 AI 模型 (client)。

第二步:选择并运行 AI 模型

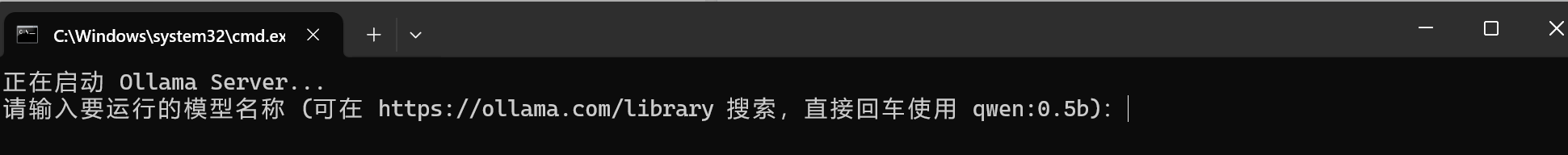

重点是第二个弹出的黑色窗口。它会提示你输入要运行的模型名称,如下所示:

Ollama 提供了许多不同的 AI 模型,你可以在 https://ollama.com/library 上找到它们,详情可见探索更多模型并安装使用。每个模型都有不同的特点和擅长的任务。

如果你是第一次使用,可以直接按下 回车键 (Enter)。 脚本会默认使用 qwen:0.5b 模型。这是一个由国内开发者开源的大语言模型,具备不错的通用能力。

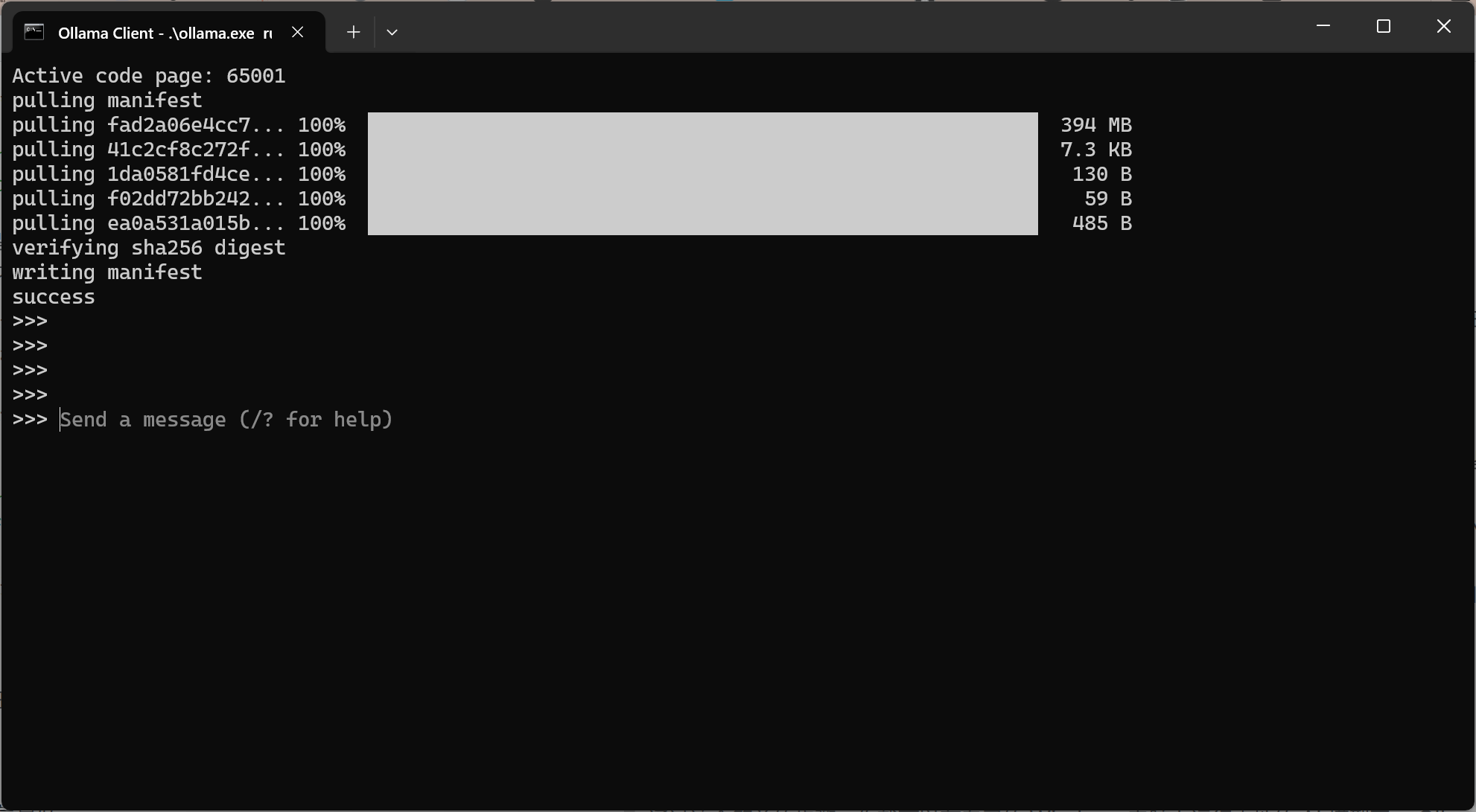

按下回车键后,命令行窗口会显示一些下载或加载模型的进度信息。耐心等待片刻,直到你看到类似这样的提示符:

这表示模型已经加载完成,你可以开始与它对话了。

第三步:与 AI 模型对话

现在,你可以在 >>> 后面输入任何你想问的问题或者想让 AI 完成的任务。 例如:

- “介绍一下光合作用的原理。”

- “帮我写一首关于秋天的诗。”

- “将这句话翻译成英文:今天天气真好。”

输入你的问题后,按下 回车键,Ollama 就会调用你选择的模型进行处理,并将结果显示在窗口中。

一些重要的提示:

- 不要关闭第一个命令行窗口! 它运行的是 Ollama 的服务器端,关闭它会导致 AI 模型停止工作。

- 你可以在 https://ollama.com/library 探索更多有趣的 AI 模型。只需要在提示符下输入相应的模型名称即可运行。

- 如果你想结束与当前模型的对话,可以在

>>>后面输入exit并按下回车键。 但 Ollama 服务仍然在后台运行。 - 如果想要彻底停止 Ollama,你需要关闭所有打开的命令行窗口。

- 有时,你可能需要允许

ollama.exe通过你的防火墙。

探索更多模型并安装使用

Ollama 的魅力在于其丰富的模型库。

你可以访问 https://ollama.com/library 来探索各种不同的模型。

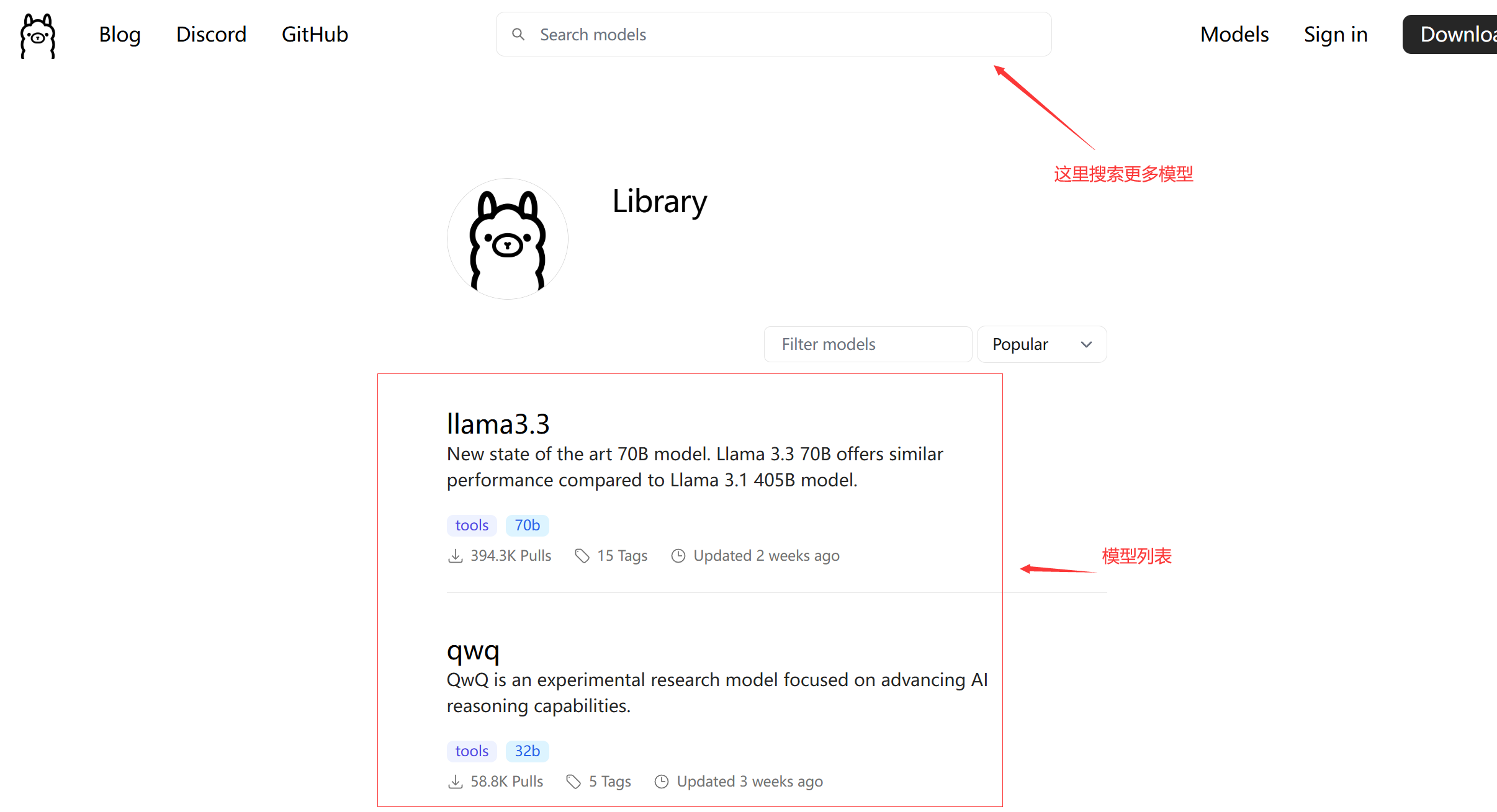

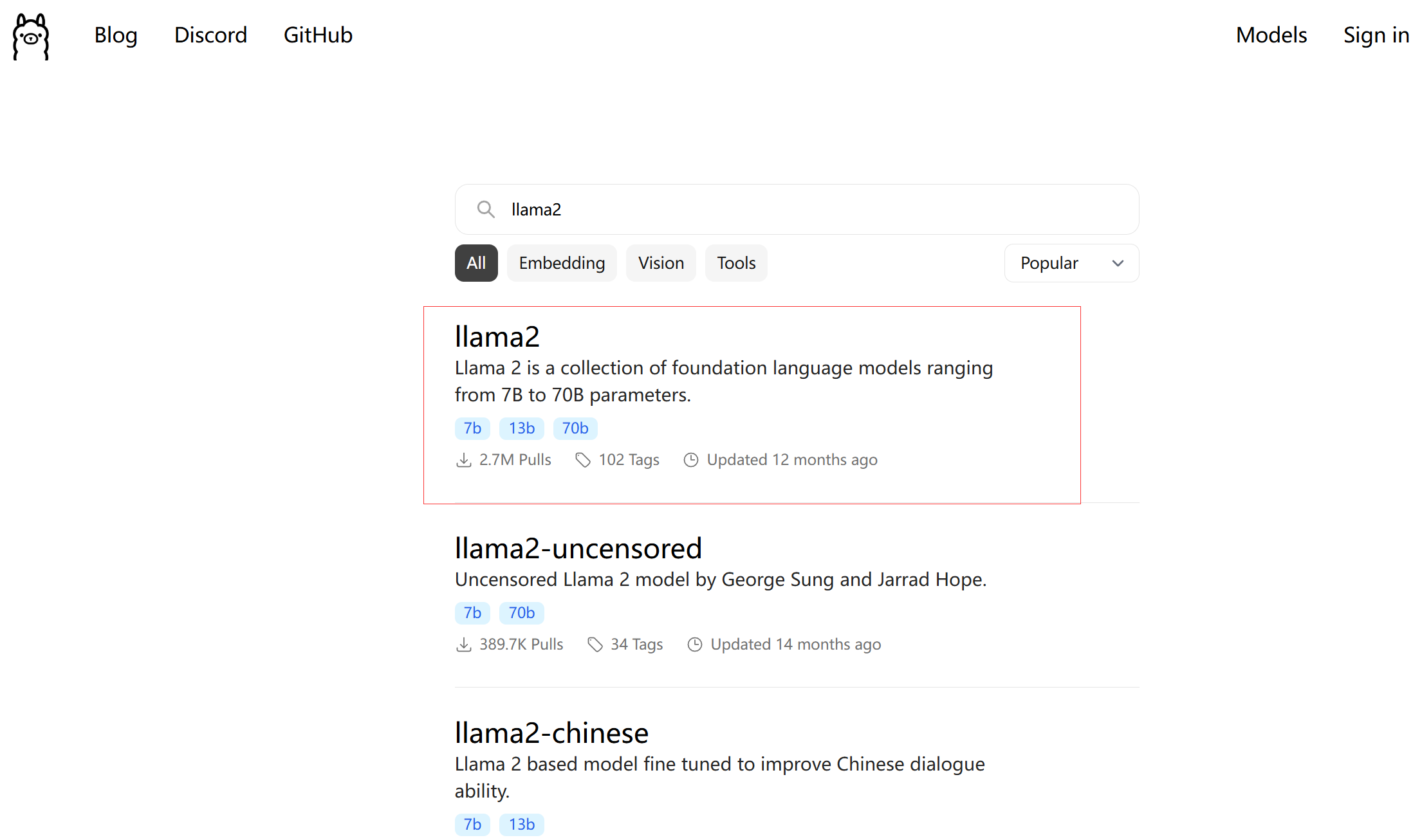

1. 浏览模型库:

打开你的浏览器,访问 Ollama 的模型库网站。你会看到各种各样的模型,它们通常会标明模型的名称、创建者、以及一些简单的描述。你可以根据自己的需求选择感兴趣的模型。例如,你可能会看到 llama2, mistral, codellama 等模型。

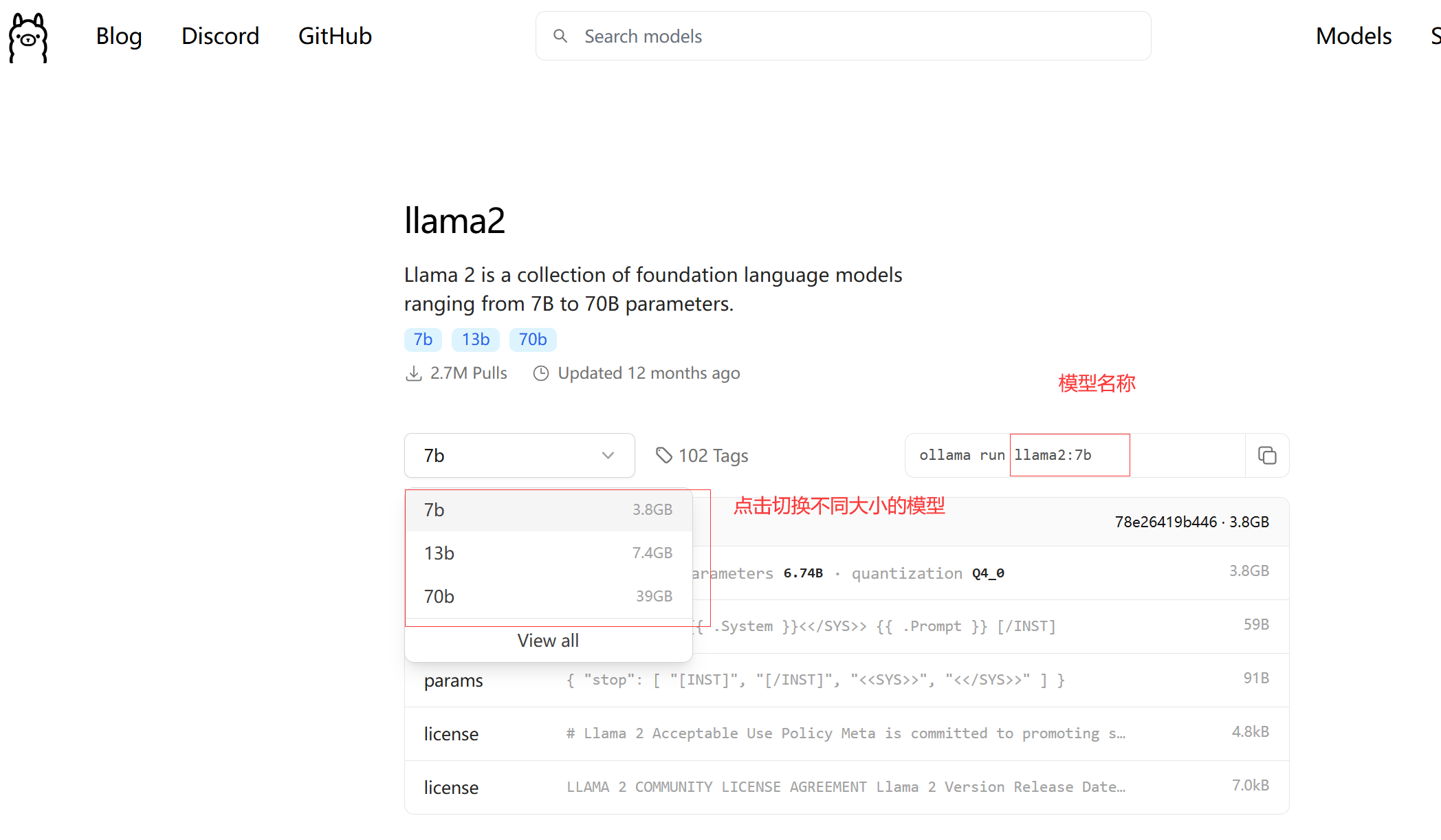

2. 安装新模型:

假设你在模型库中找到了一个名为 llama2 的模型想要尝试。 你需要重新运行脚本。 在提示 输入要运行的模型名称输入模型名称 llama2:7b。

这个命令会告诉 Ollama 下载 llama2:7b 模型。 下载过程可能需要一些时间,具体取决于你的网络速度和模型的大小。你可以在命令行窗口中看到下载进度。

3. 运行新模型:

当模型下载完成后,你就可以运行它了。 仍然在同一个命令行窗口中,或者在你与 qwen:0.5b 对话的窗口中(如果想结束当前对话,先输入 exit 并回车),重新输入模型名称 llama2:7b:

现在,你就可以和 llama2 模型进行交互了! 你会看到 >>> 提示符,然后就可以像之前一样提问或发出指令。

常见问题与解决方法

- 模型加载失败:

- 确保防火墙允许

ollama.exe访问网络。 - 检查是否输入了正确的模型名称(包括版本号)。

- 确保防火墙允许

- 字符显示乱码:

- 脚本已设置为 UTF-8 编码,确保你的 CMD 窗口使用相同编码。

- 服务未响应:

- 确保服务端窗口未关闭。

- 如果问题持续,尝试重新运行

启动.bat。

总结

通过这个简单的步骤,你就可以在自己的 Windows 电脑上运行本地的 AI 模型了。 Ollama 提供了一个便捷的方式来体验和研究各种开源的大语言模型。 快去尝试一下,探索人工智能的无限可能吧! 如果你遇到任何问题,欢迎留言讨论。